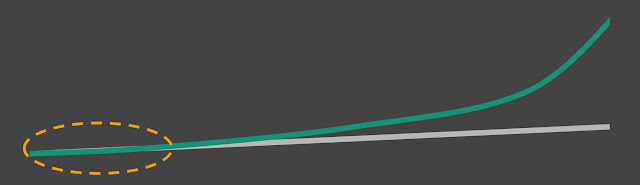

La curva "Anti Seneca" -- un collasso visto dalla direzione opposta è una rapida crescita

Vi propongo qui nel seguito la traduzione di

una parte di recente articolo di Tsung Xu, che ha gentilmente acconsentito a vederla pubblicata in Italiano. E' una discussione a tutto campo che ha il grande pregio di fare da contraltare al diffuso pessimismo che gira nel dibattito.

Non è che quello che dicono i pessimisti sia sbagliato. Assolutamente no: è vero che i fossili sono in esaurimento, che il clima sta andando a quel paese, che il pianeta è sovrappolato e, in aggiunta, che invece di cercare di fare qualcosa in proposito, ci divertiamo a giocare alla guerra. Siamo messi molto male, davanti al "

Collasso di Seneca".

Homo sapiens, col piffero!

Però è anche vero che siamo di fronte a un'opportunità unica nella storia dell'umanità. L'energia rinnovabile nella forma di solare, eolico, e qualche altra tecnologia, è una di quelle transizioni dirompenti che sta partendo e che potrebbe non fermarsi più.

La cosa bella dell'articolo di Xu è la visione dinamica. E' una caratteristica di chi riesce a vedere come si comportano i sistemi complessi -- detti anche "non lineari." In questi sistemi, i feedback negativi portano al collasso . Ma esiste anche l'effetto opposto, guidato dai feedback positivi (chiamiamolo effetto "Anti-Seneca" se volete). Quando questi effetti prendono il sopravvento, il sistema parte verso l'alto come un missile Zircon. Il gioco dei feedback porta alle oscillazioni tipo la curva di Hubbert e cose del genere.

Allora, se enfatizzate i feedback negativi, allora vedete il collasso imminente -- che in effetti è inevitabile per tutte le tecnologie basate sui combustibili fossili (incluso quella meta-tecnologia che chiamiamo "economia industriale"). Se invece enfatizzate i feedback positivi, vedete come le energie rinnovabili sono sul punto di spazzar via tutte le vecchie tecnologie energetiche, generando tutta una nuova serie di tecnologie (incluso una nuova meta-tecnologia che forse continueremo a chiamare "economia" ma che sarà completamente diversa dall'attuale).

Le due possibilità sono interdipendenti. Potremmo collassare talmente alla svelta che non ci sarà tempo per l'energia rinnovabile di svilupparsi al punto da stare in piedi da sola. Oppure, potremmo rimanere così tenacemente attaccati ai fossili da rendere impossibile la transizione alle rinnovabili, usando per esempio ostacoli burocratici, legali, eccetera.

Ma nel complesso, ci sono buone ragioni per essere ottimisti. Quantomeno abbiamo una possibilità di non ritornerare all'età della pietra! Però ci dovremo lavorare sopra.

L'articolo di Xu enfatizza i feedback positivi in una visione molto dinamica della transizione. E' quasi sempre corretto e condivisibile. Non proprio su tutto, però. Diciamo che Xu non approfondisce il discorso della necessità di materie prime per le rinnovabili, limitandosi a dire che non c'è evidenza che questa sia una limitazione grave nel breve e medio termine. Corretto, ma su tempi un po' più lunghi, la questione si pone. Anche sulla questione del riciclo, l'articolo è piuttosto limitato. Ma non è pensato come un'enciclopedia.

Diciamo piuttosto che Xu si fa prendere forse un po' troppo dall'entusiasmo per tutto quello che è nuovo, nonostante che non sia provato. Così, si lancia in una serie di lodi per il grafene, l'ultimo "materiale miracolo" fra quelli che appaiono sull'orizzonte delle meraviglie della scienza.

Si, il grafene ha proprietà particolari come materiale, ma non possiamo trascurare il fatto che non sappiamo esattamente come smaltirlo è che una cosa che non esiste normalmente nell'ecosistema e quindi non sappiamo che effetto potrebbe fare se prodotto in grandi quantità. Insomma, come con tante altre cose proposte come toccasana (tipo i "nanomateriali", oggi per fortuna in gran parte passati di moda) bisogna andarci con prudenza.

A parte questo, l'articolo è corretto e ben documentato, con una bibliografia assolutamente spettacolare. E' troppo lungo per tradurlo tutto, ve ne passo la parte iniziale. Il resto è accessibile in inglese

sul sito di Xu.

___________________________________________________________________

Di Tsung Xu: 1 Marzo 2022 –

traduzione parziale di Ugo Bardi

Per l'articolo completo, vedere.https://www.tsungxu.com/clean-energy-transition-guide/Alimentata dal solare, dal vento e dalle batterie agli ioni di litio, la transizione dell'energia pulita sta rimodellando il mondo. Poco più di un anno fa, non avrei creduto a questa affermazione.

All'epoca, non mi rendevo conto di quanto velocemente si stessero moltiplicando questi cambiamenti. Da allora ho imparato un sacco di cose sulle transizioni energetiche e sulla tecnologia del clima, ho analizzato i dati e ho triangolato le intuizioni.

Oggi, non ho dubbi sulla transizione dell'energia pulita e sull'impatto che avrà sulle nostre vite e società. La frase “transizione energetica” è anche un eufemismo e poche persone al mondo ne hanno vissuta una prima di sapere diversamente. Guardando la storia si supera la nostra amnesia collettiva per vedere quanto siano state importanti le transizioni energetiche, e si accenna al percorso che stiamo facendo ora.

Una visione molto semplificata del passaggio alle tecnologie energetiche pulite.

Questo post spiega cosa sta guidando la transizione ed esplora le opportunità emergenti. Siete nuovi sull'argomento? Questa potrebbe essere una panoramica che vi aiuta a orientarvi mentre imparate di più. State già giocando il vostro ruolo nella transizione? Potreste trovare una nuova prospettiva che sfida il vostro pensiero o vi sorprende. Potreste anche essere spinto a costruire o unirvi a un'azienda per sfruttare le enormi opportunità della transizione energetica.

Andiamo!

Introduzione

Le seguenti intuizioni sono brevi riassunti. Nella sezione "Approfondimenti" qui sotto, rivisiteremo ogni intuizione in modo più dettagliato. Nelle sezioni principali, discutiamo poi ogni punto in modo più approfondito.

Approfondimento 1: il crollo dei costi del solare e delle batterie sono ora al punto di svolta

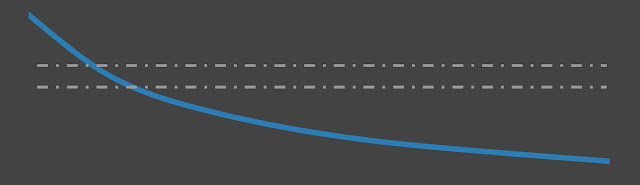

I costi delle batterie solari e agli ioni di litio continuano a scendere, e sono ora a punti di svolta di crescita sostenuta e rapida, come mostrato in questi grafici.

Nella generazione di elettricità, il solare e l'eolico si stanno rapidamente muovendo verso la sostituzione dei combustibili fossili. Nella mobilità, i prezzi delle batterie agli ioni di litio hanno permesso che i costi dei veicoli elettrici (EV) siano diventati paragonabili a quelli delle auto a benzina o gasolio.

Questi punti critici sono acceleratori che ci spingono verso un futuro di energia pulita.

Approfondimento 2: man mano che la produzione aumenta, il solare, l'eolico e le batterie diventano più economici e migliori

Possiamo produrre pannelli solari e turbine eoliche per generare energia, e batterie per immagazzinarla. Questo permette di impiegare un maggior numero di queste risorse mentre i costi diminuiscono e le prestazioni migliorano, come mostrato qui sotto.

Nelle precedenti transizioni energetiche, questo ciclo auto-rinforzante non è mai stato sostenuto per più di qualche decennio. Di conseguenza, le previsioni sulla diffusione e sui costi dell'energia pulita sono state costantemente insoddisfacenti.

Approfondimento 3: l'elettricità economica e pulita permette nuove industrie

Già storicamente a buon mercato, il prezzo dell'elettricità dal solare e dall'eolico continuerà a scendere. Il solare probabilmente guiderà la maggior parte delle riduzioni dei costi.

I prezzi dell'elettricità stanno diventando abbastanza economici da permettere alle nuove industrie elettrochimiche di prosperare, come mostrato sopra. Le opportunità emergenti includono la cattura diretta dell'aria guidata dall'elettricità e la produzione di nuovi materiali. Vedremo in seguito che gli imprenditori che vedono la velocità della transizione energetica sono quelli che ne costruiscono il futuro.

Approfondimento 4: le fonti di energia emergenti si sviluppano attraverso fasi simili

Le transizioni del carbone, del petrolio e dell'elettricità sono passate attraverso fasi simili, che potete vedere nel grafico qui sotto. Oggi anche il solare, l'eolico e le batterie stanno scalando attraverso queste fasi.

Le fonti di energia hanno cicli di feedback che si rafforzano reciprocamente con altre tecnologie, che aiutano a guidare un'ulteriore adozione. Per esempio, il motore a combustione interna e i prodotti petrolchimici hanno spinto una maggiore domanda di petrolio, permettendogli di guadagnare una quota crescente dell'uso globale di energia all'inizio e alla metà del XX secolo.

Questi cicli e fasi di feedback possono aiutare a guidare quanto siamo avanti nella transizione e quali opportunità stanno emergendo.

Crescita non lineare contro crescita lineare.

Motivazioni

L'energia (e il clima) sono problemi incredibilmente eccitanti e d'impatto su cui lavorare. Questo spazio affronta due cose nella mia mente. Uno è il rischio del cambiamento climatico, dove tutti dovremmo cercare di evitare gli esiti peggiori. Due è il continuo progresso della tecnologia energetica, senza il quale il progresso umano potrebbe ristagnare.

Per oltre un anno, ho studiato la transizione dell'energia pulita. Ho parlato con decine di fondatori di tecnologie pulite e ingegneri e ho assorbito libri, rapporti di ricerca, documenti, podcast e innumerevoli articoli.

Due cose sono diventate chiare.

In primo luogo, le tecnologie solari e delle batterie agli ioni di litio sono state il cuore della transizione energetica. Il loro rapido ritmo di adozione e la drastica riduzione dei costi sono stati senza precedenti per le tecnologie energetiche.

In secondo luogo, pochissimi addetti ai lavori con cui ho parlato o da cui ho imparato sembravano pensare che il solare e le batterie avrebbero avuto l'impatto che stavo iniziando a pensare.

Ho sbagliato? Ho capito che c'è una pletora di problemi tecnologici, di implementazione, politici e di altro tipo. Questi potrebbero frenare il cammino verso un futuro energetico pulito ed economico?

Continuando la mia ricerca, ho raccolto più dati e la convinzione che le energie pulite avrebbero avuto un impatto incredibile.

Durante le mie ricerche, non mi sono imbattuto in un articolo come questo che ho scritto, ma mi avrebbe davvero aiutato ad orientarmi. Spero che questo pezzo possa aiutare come guida per almeno alcune persone che sono curiose di conoscere la transizione e dove potrebbe andare.

Scrivendo questo testo, mi propongo di trovare colleghi che amano discutere e costruire, e che vedono le opportunità per sperimentare insieme.Perché la transizione all'energia pulita è sottovalutata

È difficile per noi comprendere ciò che non abbiamo mai vissuto. Poche persone vive oggi hanno assistito alle precedenti transizioni energetiche. Questo rende facile sottovalutare l'impatto che hanno avuto, e quanto velocemente tendono ad accadere una volta in movimento. Dopo tutto, l'ascesa del carbone, del petrolio e dell'elettricità è avvenuta più di cento anni fa nei paesi sviluppati. Poiché quasi nessuno in vita aveva vissuto l'influenza spagnola cento anni fa, il COVID ci ha mostrato quanto breve sia di solito la nostra memoria collettiva per eventi rari di scala planetaria.

È facile pensare che la rapida scalata della tecnologia solare, eolica e delle batterie non possa essere sostenuta. Ogni transizione passa attraverso dolori di crescita. Ma quando c'è una domanda insaziabile, le industrie trovano il modo di soddisfarla. Questo è stato il caso del carbone, del petrolio e dell'elettricità, come vedremo, ed è il caso oggi delle energie pulite a basso costo. C'è la preoccupazione correlata che le riduzioni decennali dei costi per il solare e le batterie appiattiscano la loro curva di crescita. Come vedremo, questo è molto improbabile. La tecnologia e i processi esistenti continueranno a migliorare e nuove tecnologie saranno commercializzate.

È difficile pensare alle tecnologie e al cambiamento come se fossero non lineari. Mostriamolo con un esempio. Supponiamo di iniziare con un granello di sabbia. Diciamo che questo granello si duplica ogni anno. Quanti anni ci vorrebbero perché questo granello si replichi nel numero totale di granelli di sabbia sulla Terra? Supponiamo che ci siano 7,5 miliardi di miliardi (7,5 x 10^18) di

granelli di sabbia nel mondo. Qual è la risposta? 10.000 anni? 1,000? In realtà, ci vorrebbero meno di 63 anni o raddoppi. Se il granello di sabbia solitario si duplica ogni due anni (cioè cresce al 41,4% all'anno), ci vuole solo il doppio del tempo per raggiungere quel traguardo. Questi esempi sembrano estremamente controintuitivi, ma è difficile per le persone pensare in

questo modo. Chi ha esperienza di startup tende a capire meglio il pensiero non lineare, perché la trazione iniziale e la

crescita sono tutto. Il solare, l'eolico e le batterie sono cresciuti e continueranno a crescere per qualche tempo in questo modo. Il problema è che su un orizzonte temporale di pochi anni, la crescita accelerata sembra ingannevolmente lineare, come mostrato qui.

Il solare è cresciuto ad una media di quasi il 40% ogni anno dal 1976, quando abbiamo cominciato ad avere dei dati affidabili. Dall'esempio dei granelli di sabbia, si potrebbe riconoscere che si tratta di un quasi raddoppio ogni due anni. Quanto pensate che la capacità solare installata sia cresciuta da allora? Di oltre due milioni di volte. Naturalmente, questi tassi di crescita rallenteranno man mano che ci muoviamo lungo la

curva a S. Ma abbiamo già installato abbastanza solare per essere solo ad un fattore 15 di distanza da diventare la fonte primaria di generazione di elettricità a livello globale.

Nel nostro tempo, c'è la percezione che non possiamo scalare velocemente i prodotti fatti di atomi come quelli di bit. La saggezza convenzionale sostiene che il software scala meglio dell'hard tech. Come vedremo, questa percezione non è vera, dato che alcuni prodotti fisici nelle industrie clean tech stanno scalando molto, molto velocemente. Questo punto di vista probabilmente blocca molte persone brillanti e motivate nei paesi sviluppati che lavorano su tecnologie complesse e difficili. Tuttavia, ci sono segni promettenti che più persone stanno cercando di lavorare nell'energia pulita e nel clima.

Costi in calo per il solare e le batterie. Vedere le cifre qui sotto.

Costi in calo per il solare e le batterie. Vedere le cifre qui sotto.

I punti chiave da prendere in considerazione

Diamo un'occhiata più da vicino alle quattro intuizioni principali dell'introduzione.

1) I costi del solare e delle batterie stanno crollando a picco

Il solare è già diventato la fonte di energia più economica della storia, insieme al vento. Dal 1976, i costi solari (in dollari per watt)

sono scesi in media di oltre il 12% all'anno. Dalla prima commercializzazione nel 1991, i costi delle batterie agli ioni di litio (in dollari per kWh)

sono scesi in media del 12,9% all'anno. Questi prezzi in calo del solare, dell'eolico e delle batterie hanno recentemente raggiunto dei punti critici che guideranno una crescita continua.

Il costo degli elettroni solari o eolici è

ora più economico del funzionamento delle centrali fossili esistenti in molte parti del mondo. Questo è un punto di svolta che fa crescere sostanzialmente la dimensione del mercato dell'energia solare ed eolica.

Fatto usando i dati di IRENA. Come mostrato sopra, questo ha portato il solare e l'eolico a superare il 75% della nuova capacità globale di generare elettricità nel 2020, rispetto alle basse percentuali a una cifra nei primi anni 2000. Mentre i costi continuano a scendere, il solare e l'eolico continueranno a superare i combustibili fossili in più regioni.

Le batterie agli ioni di litio stanno raggiungendo soglie di costo tali da poter alimentare il boom dei veicoli elettrici e dello stoccaggio stazionario.

La Tesla Model 3 è economica quanto i modelli a benzina concorrenti di Audi, Mercedes e BMW, ma

li ha superati tutti in termini di vendite nel 2020. Nei prossimi anni, un numero crescente di modelli elettrici puri in più paesi diventerà economico come i concorrenti a benzina. Le batterie a basso costo e ad alte prestazioni stanno rendendo i veicoli elettrificati sempre più competitivi dal punto di vista dei costi, dalle due ruote alle barche e ai camion elettrici.

Immagazzinare l'elettricità in grandi batterie sta facendo scendere il costo dell’energia pulita. Le distribuzioni di batterie nelle reti negli Stati Uniti, in Cina e in altre aree stanno aumentando vertiginosamente, e sono sempre più spesso abbinate a impianti solari su scala industriale. Quando sono accoppiati, il solare e le batterie sono reciprocamente vantaggiosi, essendo

più preziosi delle batterie da sole.

2) Con l'aumento della produzione, il solare, l'eolico e le batterie diventano più economici e migliori

Stiamo assistendo a una crescita sostenuta e incredibile di queste tecnologie di energia pulita. Il solare è la fonte di energia in più rapida crescita nella storia.

L'elettricità generata dal solare è cresciuta a

quasi il 40% di tasso annuo composto (CAGR)

1 negli ultimi venti anni. Anche il vento non è da meno, avendo generato quasi il 22% in più di elettricità ogni anno, in media, durante lo stesso periodo.

Nel frattempo, i veicoli elettrici (EV) e lo stoccaggio su larga scala stanno guidando la domanda di batterie agli ioni di litio in piena espansione. Le vendite di veicoli elettrici sono cresciute a circa il 57% CAGR negli ultimi nove anni, come mostrato in questo grafico. Lo stoccaggio per la rete sta tenendo il passo, con una

crescita globale delle batterie del 58% CAGR negli ultimi otto anni.

Realizzato utilizzando i dati di

EV Volumes.

Questo boom emergente nella domanda di batterie agli ioni di litio ha creato alcune delle aziende che crescono più velocemente al mondo come Tesla, CATL e altre.

Il solare, l'eolico e le batterie sono tecnologie energetiche prodotte, non estratte dalle miniere. Di conseguenza, la rapida crescita della loro diffusione permette diminuzioni di costo e migliori prestazioni più simili ai chip dei computer o all'elettronica che ai combustibili fossili. Il carbone e il gas semplicemente non possono continuare a rimanere competitivi. Mentre le centrali a carbone e a gas naturale sono diventate

più economiche da costruire man mano che se ne sono sviluppate di più (capex), il costo dei combustibili stessi è effettivamente

salito nel corso di decenni di sviluppo, facendo aumentare i costi operativi.

Una cosa interessante è che la produzione di solare, eolico e batterie richiede l'estrazione e la lavorazione di minerali. Ma una volta prodotti, a differenza dei combustibili fossili, non sono necessarie ulteriori estrazioni. Questo ciclo di feedback auto-rinforzante è mostrato nel diagramma qui sotto.

Mentre i costi sono crollati, le caratteristiche del solare e delle batterie continuano a migliorare. La tecnologia solare fotovoltaica (PV) si è sviluppata con molti miglioramenti in tutta la catena di fornitura. Anche le caratteristiche delle batterie come la densità di energia, il numero di cicli e la sicurezza sono migliorate rapidamente.

3) L'elettricità economica e pulita permette nuove industrie

Il solare e l'eolico ora generano gli elettroni più economici della storia, e stanno continuando a diventare più economici. Questo continuerà a far abbassare i costi dell'elettricità, specialmente per gli usi commerciali e industriali.

LCOE significa costo livellato dell'elettricità. Vedere la versione in inglese per le fonti di dati e l'approccio all'aggiustamento dei prezzi per l'inflazione.

Come mostrato nel grafico qui sopra, i grandi consumatori di energia elettrica degli Stati Uniti hanno forti incentivi ad acquistare direttamente l'elettricità dalle centrali solari ed eoliche.

Anche il ritmo delle riduzioni dei costi per gli elettroni generati dal solare è un record storico. La caduta dei costi dell'elettricità creerà industrie che stanno emergendo ora, così come quelle che devono ancora emergere.

Per esempio, le startup stanno scommettendo su elettroni economici per alimentare la cattura e/o la conversione della CO2. La cattura diretta rimuove la CO2 dall'aria. La CO2 può poi essere convertita elettrochimicamente in materiali a base di carbonio, carburanti e altri prodotti. Anche altre industrie sono destinate a trarre vantaggio dal costo inferiore dell'elettrificazione.

Il grafene e i materiali monostrato erano stati isolati e inventati vent'anni fa. Oggi, questi materiali sono sempre più utilizzati in un numero crescente di mercati di nicchia. Gli elettroni puliti ed economici potrebbero giocare un ruolo chiave nell'accelerare l'adozione di materiali emergenti come il grafene.

4) Le fonti di energia emergenti si sviluppano attraverso fasi simili

Prima di tuffarci nella transizione dell'energia pulita, è molto utile acquisire un modello mentale di come si sono svolti momenti analoghi nella storia. Mentre ci sono molte differenze, ci sono anche paralleli tra le transizioni energetiche del passato e questa.

Esploreremo per prima cosa l'ascesa del carbone, del petrolio e dell'elettricità e dove si trovano oggi. È facile pensare che il progresso avvenga molto più velocemente oggi che in passato. Questo è vero per certi versi, ma vedremo che alcune tecnologie alimentate dall'energia si sviluppano in modo sorprendentemente rapido, anche per gli standard odierni.

Andamento approssimato della quota di carbone, petrolio ed elettricità nell'uso globale di energia nel tempo. Vedere il grafico più avanti nella sezione. Le statistiche e i riferimenti in questa sezione sono tratti da Energy, A Human History di Richard Rhode.

1 Modelli delle precedenti transizioni energetiche

Quando ho esaminato per la prima volta la crescita del carbone, del petrolio e dell'elettricità, sono rimasto sorpreso di trovare modelli simili per tutte. Queste transizioni energetiche chiave nella storia passano tutte attraverso fasi simili, come mostrato nella figura qui sotto. Dopo essere stata scoperta, la fonte di energia (o il vettore nel caso dell'elettricità) trova un punto d'appoggio in mercati di nicchia dove supera gli operatori storici. Col tempo, quando la tecnologia matura, può entrare in mercati più grandi. Poi, nella fase più trasformativa, emergono nuove infrastrutture per la fonte di energia, vengono abilitati nuovi materiali ed emergono nuove industrie.

Fasi iniziali di una transizione energetica. Man mano che la fonte di energia si espande in mercati più grandi, guadagna in uso rispetto ad altre fonti di energia.

All'inizio di una transizione energetica, c'è spesso più attenzione su quanto bene possano fare le cose esistenti. Gli esempi includono quanto bene il carbone possa riscaldare e il petrolio e l'elettricità possano illuminare. Ma l'impatto maggiore per qualsiasi transizione energetica, come per altre nuove tecnologie, è quello di permetterci di

fare cose nuove.

Prendete un addetto ai motori a vapore in Gran Bretagna nel 1800, quando i motori a vapore erano per lo più limitati al pompaggio dell’acqua nelle miniere di carbone e all'industrializzazione del ferro. Avrebbero potuto concepire che entro cinquant'anni, queste macchine alimentate a carbone avrebbero guidato persone e rifornimenti attraverso i binari posati in tutto il paese? O che cinquant'anni dopo, i grattacieli fatti di acciaio (usando forni a coke - carbone riscaldato -) avrebbero cominciato a spuntare nelle grandi città?

O prendete un appassionato di auto a New York, nel 1900, quando c'erano solo una manciata di auto a benzina su strade dominate dai cavalli. Avrebbero mai creduto che solo 13 anni dopo, le strade di Manhattan sarebbero state piene di automobili e si sarebbero trovati pochi cavalli? O che trent'anni dopo il petrolio avrebbe cominciato ad essere raffinato in polimeri e plastica?

Infine, prendete un innovatore dell'elettricità negli Stati Uniti nel 1890, quando le prime reti elettriche in tutta la città erano state installate da meno di dieci anni, per lo più utilizzate per alimentare le luci. Avrebbero mai pensato che l'alluminio, che non molto tempo prima era più costoso dell'oro, sarebbe stato presto prodotto commercialmente usando l'elettricità? O che entro la fine dei ruggenti anni 20, più di

due case americane su tre avrebbero avuto accesso all'elettricità?

Le transizioni si rafforzano a vicenda. Migliori tecnologie di distribuzione e materiali guidano un'ulteriore adozione e investimenti nella fonte di energia.

Ho trovato qualcos'altro di sorprendente nelle precedenti transizioni energetiche. Ognuna di esse ha successivamente abilitato nuove modalità di trasporto e nuovi materiali che erano molto difficili da concepire durante le sue prime fasi. In ognuna delle transizioni passate, la fonte di energia ha sbloccato nuove tecnologie di distribuzione e materiali che hanno aiutato a guidare l'adozione della fonte di energia stessa. Come vedremo più avanti, lo stesso vale per il solare, l'eolico e le batterie.

Diamo un'occhiata più da vicino a ciascuna di queste transizioni passate come guida a ciò che potrebbe essere in serbo per la porta della transizione dell'energia pulita.

1.1 Carbone: vapore, locomotive e ferro

Nicchia iniziale

Nel 17° secolo, la legna scarseggiava in Inghilterra. I prezzi salivano vertiginosamente, dato che la popolazione di Londra era aumentata di 8 volte tra il 1500 e il 1650, determinando una maggiore domanda di legna da ardere. Man mano che le foreste venivano abbattute, la legna doveva essere trasportata su strade fangose sempre più lontane dai centri abitati. Questo creò l'opportunità di un'alternativa per servire il paese in piena espansione.

Nonostante il suo fumo un po' tossico, il carbone era più economico e più facile da commercializzare del legno. Nel XVII secolo, le miniere di carbone erano situate vicino ai fiumi. In questo modo, il combustibile poteva essere spedito su barche a Londra e in altri luoghi per fondere il ferro o costruire navi. Con il boom di Londra, le spedizioni di carbone verso la città aumentarono di più di un ordine di grandezza durante il secolo.

Ma le prime miniere di carbone erano pericolose, spesso si allagavano e uccidevano i minatori. Le prime macchine a vapore alimentate a carbone, inventate da Thomas Newcomen nel 1712, meccanizzavano il pompaggio dell'acqua fuori dalle miniere. Erano stazionarie e grandi come una piccola casa, ma sufficienti per evitare le inondazioni. Il loro uso salvò la vita di molti minatori e permise la prima scalata industriale dell'estrazione del carbone.Il commercio della ghisa: l’espansione del mercato

Negli anni 1740 il carbone era già utile non solo per il riscaldamento degli ambienti. La Coalbrookdale Company fu la prima ditta a usare il carbon coke per fondere il ferro, permettendo la produzione di massa di ghisa per la prima volta nella storia. L'azienda usò anche i motori a vapore di Newcomen per sostituire le pompe azionate dai cavalli, riducendo i costi nel processo. Meno di 60 anni dopo, il ferro aveva sostituito il legno nella maggior parte degli usi di produzione e costruzione in Gran Bretagna.

Prima del XIX secolo, le miniere di carbone si limitavano ad essere vicine ai corsi d'acqua. Le strade e i cavalli non erano adatti, e così il carbone veniva caricato sulle barche. Questo significava che il carbone doveva ancora essere trasportato dalla miniera all'acqua, usando all'inizio binari di legno.

Tecnologie che si rafforzano reciprocamente mentre il carbone diventa la fonte di energia primaria a livello globale entro il 1910.

Locomotive: distribuzione

Le ferrovie furono sviluppate per risolvere questo problema. Verso la fine del XVIII secolo vennero sviluppati motori a vapore a pressione più alta, e all'inizio del XIX secolo vennero utilizzati progetti migliori per alimentare le locomotive a vapore. I binari ferroviari passarono dall'essere fatti di legno alla ghisa e poi al ferro battuto in questo periodo, permettendo alle ferrovie di iniziare a trasportare carbone, carichi di altro genere e persone. Le miniere di carbone potevano essere costruite sempre più lontano dai fiumi.

In altre parole, la produzione industriale di ferro e le macchine a vapore, entrambe basate sul carbone, aiutarono a liberarsi dalle limitazioni iniziali di approvvigionamento del combustibile. Queste tecnologie si rafforzarono a vicenda e il loro impatto sarebbe stato difficile da comprendere nel XVII secolo. Permisero di fare cose completamente nuove.

Una volta che l'offerta di carbone fu libera, la produzione crebbe rapidamente nel XIX secolo e si diffuse dall'Inghilterra all'Europa e agli Stati Uniti. Ha permesso alla produzione di ferro di raddoppiare ogni 10 anni dal 1788 per decenni. Se invece del carbone fosse stato usato il carbone di legna per fare i binari di ferro,

semplicemente non ci sarebbe stata abbastanza legna in Inghilterra.

Commercializzazione della produzione di acciaio

Una svolta nella produzione dell'acciaio alla fine degli anni 1850, il processo Bessemer, avrebbe aiutato gli Stati Uniti a catapultare la produzione di acciaio oltre 400 volte dal 1867 al 1900. A quel punto, gli Stati Uniti producevano un terzo della produzione mondiale. Proprio come allora, ancora oggi, la produzione di acciaio utilizza in gran parte coke ricavato dal carbone.

La transizione dal legno al carbone per i paesi in via di industrializzazione è stato il cambiamento energetico più veloce e drammatico fino a quel momento nella storia dell'umanità. Fino ad allora, avevamo usato la biomassa a base di legno per il calore e le materie prime per milioni di anni.

Realizzato utilizzando i dati di Our World In Data. Dati precedenti al 1800 stimati in base al consumo di carbone nel periodo che sale dal ~0% nel 1700. Nel 1900, il carbone era dominante, come mostrato in questo grafico. Forniva oltre il 90% dell'energia del Regno Unito e il 70% di quella degli Stati Uniti.

Ma solo dieci anni dopo, l'uso del carbone avrebbe raggiunto il picco, in gran parte perché il petrolio era in rapida ascesa.

1.2 Petrolio, motori a combustione interna e polimeri

Nicchia iniziale

Il prodotto-mercato iniziale adatto al petrolio era l'illuminazione. La ricerca del petrolio fu guidata dalla ricerca di una materia prima più economica per il cherosene, un olio per l'illuminazione che era stato precedentemente raffinato dal carbone. Il primo pozzo negli Stati Uniti, scavato con un motore a vapore, iniziò a produrre nel 1859. Il petrolio poteva essere raffinato in cherosene e solo 6 anni dopo il mercato del petrolio per l'illuminazione aveva già decuplicato la produzione.

La corsa al petrolio era iniziata, inizialmente negli Stati Uniti a Titusville, in Pennsylvania. Ma, come per il carbone, c'erano problemi di trasporto e stoccaggio da superare. Ci vollero 3 anni per un collegamento ferroviario per la città, e un altro anno per il primo oleodotto da ferrovia a pozzo.

La Standard Oil di John D. Rockefeller era l'emergente raffinatore di petrolio dominante. Consolidò l'offerta e fece accordi per ridurre i costi del cherosene del 55% dal 1865 al 1870. La Standard Oil spinse l'efficienza nella raffinazione, incluso l'uso della benzina per aiutare le raffinerie. Prima che la benzina trovasse un mercato nei motori a combustione interna, altri raffinatori la scaricavano, spesso nei fiumi. Sembra incredibile oggi, ma allora volevano solo fare cherosene.

Nel 1870, il cherosene, più economico e raffinato, aveva conquistato il mercato dell'illuminazione negli Stati Uniti. Ma nonostante la fornitura di quasi 5 milioni di barili prodotti in Pennsylvania quell'anno, l'illuminazione era ancora solo un primo passo verso mercati più grandi. Non ci sarebbe stato un mercato più grande per il petrolio, e forse per qualsiasi altra fonte di energia fino ai nostri tempi, che il motore a combustione interna.

Motori e automobili: distribuzione

Il successo del motore a combustione interna (ICE) sarebbe diventato il motore principale della domanda di petrolio per il XX secolo.

Intorno al 1900, le auto con motore a vapore e persino le auto elettriche a batteria erano più popolari delle auto ICE negli Stati Uniti. In Europa,

la Porsche P1 (che sta per Porsche numero 1), fu costruita nel 1898 con una batteria al piombo. Tuttavia, il vantaggio iniziale dell'adozione delle auto a vapore ed elettriche sarebbe stato di breve durata. Pur essendo una tecnologia matura, i motori a vapore erano complicati da far funzionare e piacevano soprattutto ai primi hobbisti. I veicoli elettrici mancavano di infrastrutture di ricarica al di fuori delle città, in un periodo in cui molte più persone vivevano in zone rurali.

Nel 1900, i veicoli ICE non avevano la maturità tecnologica dei motori a vapore, né la semplicità delle auto elettriche. Ma grazie al boom del petrolio, le auto ICE avevano infrastrutture di rifornimento distribuite in tutti gli Stati Uniti. Nei decenni precedenti, la benzina derivata dal petrolio aveva trovato molti usi al di fuori delle città, usata come detergente e solvente. Gli agricoltori avevano adottato motori a benzina stazionari per "tutto, dalle lavatrici ai mulini per il grano".

5 Questo significava che i negozi generali nelle aree rurali e urbane erano riforniti di benzina.

Nella foto del 1900, l'auto è quasi al centro. Nel 1913, diversi cavalli sul lato destro della foto. Fonti per le foto del 1900 e del 1913. La benzina aveva una distribuzione superiore e le automobili erano sempre più convenienti. Nel 1914, c'erano quasi 1,7 milioni di veicoli a motore registrati negli Stati Uniti, un mercato che è cresciuto con un CAGR del 46% in 14 anni. Vedi la foto scattata nel 1913 sulla 5th Avenue qui sopra. Solo 13 anni prima, nel 1900, non c'erano quasi auto sulla strada. Questa è stata una transizione straordinariamente rapida, che, come discuteremo più avanti, è di buon auspicio per i veicoli elettrici nel 2020.

Quasi tutti i veicoli venduti a quel tempo erano alimentati a ICE. La Ford Model T aveva aiutato a scalare rapidamente l'adozione dei veicoli ICE abbassando i costi in modo drammatico. Henry Ford progettò l'auto per avere meno parti (meno di 100) che erano intercambiabili tra le auto, aumentando notevolmente l'efficienza degli operai e semplificando il processo di produzione.

Tecnologie che si rafforzano reciprocamente con il petrolo che cresce fino a diventare la principale fonte di energia a livello globale alla fine del 20° secolo.

Polimeri: una nuova classe di materiali

I polimeri derivati dal petrolio sarebbero diventati una classe completamente nuova di materiali. La bachelite,

inventata nel 1907, fu il primo polimero sintetico e fu effettivamente ricavato dal carbone. Fu usata come isolante elettrico per gli Stati Uniti in rapida elettrificazione e in tutto, dalle radio, ai ferri da stiro, ai pettini, come

lodò la rivista Time in una copertina del 1924. Il successo della bachelite diede il via a una corsa tra le aziende chimiche per scoprire nuovi polimeri sintetici, anche se all'inizio non avevano usi.

L'investimento di R&S nei polimeri sintetici da parte di molte aziende chimiche ha iniziato a dare i suoi frutti negli anni '30. Il

nylon fu inventato e usato nella seconda guerra mondiale (e ancora oggi) per paracaduti, corde e calze. Il plexiglass fu usato nei finestrini degli aerei e il polietilene

6 fu usato per gli imballaggi.

Realizzato utilizzando i dati di Our World in Data. ICE = motore a combustione interna Proprio come per il carbone, l'uso diffuso e la distribuzione del petrolio permisero lo sviluppo e l'uso in scala di nuovi materiali, come mostrato qui. Furono create intere nuove industrie.

Per quanto importante, un punto chiave ha limitato l'ascesa del petrolio è stato il costo. Il petrolio non è mai stato abbastanza economico per produrre elettricità, a differenza del carbone, o più tardi del gas naturale e ora del solare e dell'eolico.

Parallelamente all'ascesa del petrolio, anche l'elettricità stava guadagnando terreno. Nonostante il suo impatto già enorme nel 20° secolo, l'elettrificazione è appena iniziata.

1.3 Elettricità, alluminio e linee di trasmissione

Nicchie iniziali

Dopo più di un secolo di progressi nella ricerca, l'elettricità doveva ancora essere commercializzata a metà del XIX secolo. Alcuni primi usi come il telegrafo e il telefono si erano già dimostrati utili. Tuttavia, a quel tempo, non c'erano casi d'uso che richiedevano fonti più abbondanti di elettroni.

La commercializzazione della lampadina a incandescenza da parte di Thomas Edison nel 1879 fu la prima killer app. Le lampadine erano più luminose e duravano molto di più delle lampade a cherosene. Ironicamente, il petrolio aveva iniziato a sostituire il carbone nella fornitura di cherosene solo venti anni prima dell'invenzione di Edison.

La prima adozione della luce elettrica fu rapida. Nel 1882, solo tre anni dopo, Edison aveva installato la prima centrale elettrica commerciale degli Stati Uniti nella bassa Manhattan, inizialmente per 82 clienti in pochi isolati. Due anni dopo, Edison riforniva oltre

500 persone con più di 10.000 luci elettriche.Le prime guerre per la distribuzione

L'elettricità poteva essere trasmessa solo a distanze molto limitate e utilizzava un'infrastruttura a corrente continua (DC) all'epoca. Edison sosteneva la corrente continua, ma i fili di rame si fondevano se trasmessi su lunghe distanze. Inoltre, c'era un limite al numero delle centrali a carbone inquinanti che la gente poteva tollerare vicino alle città.

C'è voluto un passaggio dalla corrente continua alla corrente alternata (AC) per distribuire l'elettricità molto più ampiamente di alcuni isolati di città. Una volta sviluppata e testata negli anni 1880-90, poteva trasmettere elettroni a decine di miglia inizialmente, con una gamma di trasmissione che aumentava con tensioni più alte.

Tecnologie che si rafforzano a vicenda nell'ascesa dell'elettricità nel XX secolo.

La commercializzazione dell'alluminio

L'elettricità generata era anche abbastanza economica da permettere la produzione di materiali come l'alluminio per la prima volta in modo economico.

Quando fu aperta nel 1895, l'energia idroelettrica delle cascate del Niagara fu usata per alimentare il terzo impianto di fusione di Alcoa. Prima che l'elettrolisi del suo ossido fosse possibile con elettroni più economici, il metallo era difficile e costoso da raffinare dal minerale. Era più costoso dell'oro e, di conseguenza, raro.

La produzione globale di alluminio sarebbe aumentata di 15 volte dal 1900 al 1916, quando i costi di elettrolisi scesero e il metallo trovò più usi. I fratelli Wright usarono un motore d'aereo in

lega di alluminio nel 1903, e l'alluminio cominciò ad essere ampiamente utilizzato negli

aerei della seconda guerra mondiale e nei satelliti durante la corsa allo spazio.

L'alluminio ha anche sostituito il rame nelle linee di trasmissione, permettendo alle linee a lunga distanza di essere economicamente più fattibili. Era più economico, più leggero e permetteva di costruire torri di trasmissione più leggere (e anche più economiche), nonostante non fosse conduttivo come il rame.

Dispositivi elettrificati: mercati in crescita

Le case e gli edifici divennero sempre più elettrificati, con circa

cinque famiglie su sei collegate alla rete entro la fine degli anni '20. L'uso dell'elettricità per famiglia continuò a crescere man mano che si diffondevano gli elettrodomestici, specialmente dopo la seconda guerra mondiale. Lavatrici, frigoriferi, televisori, condizionatori d'aria, lavastoviglie

si fecero strada nelle case dei paesi sviluppati entro gli anni '70.

La crescente elettrificazione dell'uso dell'energia significava che una quota maggiore di combustibili fossili (carbone e gas in particolare) produceva elettricità, e non per altri usi finali. Come mostrato sopra, nel 1900,

meno del 2% della produzione mondiale di combustibili fossili era convertita in elettroni, ma entro il 2020, quasi il 40% lo sarebbe stato. I combustibili fossili stanno diventando meno competitivi con il solare, il vento e le batterie, i nuovi nati del blocco energetico. Ora, c'è un'altra transizione ben avviata.

1.4 L'energia pulita è in aumento

Nonostante tutti i loro vizi e limiti, il carbone e il petrolio hanno alimentato il rapido progresso tecnologico e migliorato il tenore di vita di miliardi di persone. Ma l'era dell'uso di piante morte preistoriche per alimentare le nostre economie sta per finire. Guardiamo le transizioni energetiche attraverso la lente dei cicli di innovazione, ripensando a quanto sia difficile capire la crescita non lineare.

Le nuove tecnologie sostituiscono la quota di mercato degli

incumbent prima lentamente, poi rapidamente. Questo è anche vero per le aziende dirompenti che prendono quote di mercato nelle industrie esistenti.

All'inizio della figura qui sopra, l'incumbent ha un'alta quota relativa di mercato e sembra mantenere bene la quota. Tuttavia, la nuova tecnologia è in aumento. Sta crescendo ad un tasso non lineare per prendere quote di mercato ogni anno dall'incumbent. Prima che l'incumbent possa reagire, il nuovo lo ha già superato nella quota di mercato.

Questo è successo più e più volte nel corso della storia. I cavalli sono scomparsi dalle strade quando le auto ICE hanno preso il sopravvento; la quota offline dei dollari della pubblicità è stata sostituita dagli annunci online; Nokia non ha risposto all'ascesa degli smartphone; i taxi sono stati per lo più usurpati dal ridesharing. L'incumbent disruption si applica anche all'industria energetica e alle transizioni energetiche. Poche persone in vita hanno vissuto abbastanza a lungo per essere parte di una di esse, a differenza di molti degli esempi che ho appena dato.

Come si svolgono le transizioni

Nel grafico qui sotto, vediamo una visione generale di come si sono svolte le transizioni energetiche dal carbone al petrolio e all'elettrificazione. Ho incluso solo queste tre perché sono le fonti di energia (vettore energetico nel caso dell'elettricità) più importanti e dominanti a livello globale.

Realizzato utilizzando i dati di Our World in Data, BP Statistical Review e Vaclav Smil. *Vedi 9 su come l'elettricità viene convertita usando il metodo della sostituzione.La quota del carbone nel consumo globale di energia aveva già

raggiunto il suo massimo intorno al 1910, quando la crescente adozione di veicoli a combustione interna (ICE) ha permesso al petrolio di iniziare rapidamente a rosicchiare quote al carbone. Negli anni '70, il petrolio era la fonte di energia più importante, con un picco di oltre il 40% del consumo globale di energia durante le

crisi petrolifere degli anni '70. L'uso del gas naturale è aumentato solo un po' dal 14% nel 1985 al 24% nel 2019,

nonostante la produzione statunitense sia aumentata drasticamente dal 2005.

L'elettrificazione dell'energia ha avuto un ruolo crescente negli ultimi 120 anni. Circa il 40% dell'uso globale dell'energia è elettrificato, usando il metodo della sostituzione. Un'altra lente sull'aumento dell'elettricità è che oltre il 30% del carbone e del gas (soprattutto) viene convertito in elettricità a livello globale, perché questo è un uso molto produttivo di quei combustibili fossili oggi.

L'energia pulita è in crescita accelerata

Negli ultimi 10 anni, il solare e l'eolico hanno guadagnato sul carbone nella generazione di elettricità. Hanno generato l'1% dell'elettricità globale nel 2007 e si stavano avvicinando al 10% nel 2020.

Realizzato utilizzando i dati della BP Statistical Review. Questa è l'elettricità e non tutta la generazione di energia, quindi esclude le fonti non elettrificate - petrolio per il trasporto, combustibili fossili per l'industria e il riscaldamento, ecc. I combustibili fossili sono sempre meno competitivi rispetto al solare e all'eolico nella produzione di elettricità. Le nuove centrali solari ed eoliche sono

più economiche da costruire rispetto alle centrali a carbone e a gas esistenti in quasi metà del mondo. Questo ha molto a che fare con il motivo per cui oltre l'80% della nuova capacità elettrica nel 2020 proveniva da fonti rinnovabili, e la stragrande maggioranza di queste proveniva dal solare e dall'eolico. È solo una questione di anni, non di decenni, prima che il mondo costruisca quasi esclusivamente centrali elettriche pulite a basse emissioni di carbonio. Presto, ci saranno più smantellamenti di centrali a carbone e gas che nuovi impianti solari ed eolici aggiunti.

Fatto usando i dati di IRENA. Questa tendenza è chiaramente visibile nel grafico qui sopra. La quota di nuova capacità elettrica dal solare e dall'eolico ha superato il 75% nel 2020, essendo aumentata da meno del 6% circa nella metà degli anni 2000. In quel periodo, i combustibili fossili si sono ridotti dal contribuire a più dell'80% della nuova capacità a meno del 20%.

Questa è un'inversione notevole in venti anni.

Nonostante i rapidi progressi, il solare e l'eolico devono affrontare i dolori della crescita. Tornerò alle grandi sfide come l'intermittenza, cioè l'energia solo quando il sole splende o il vento soffia, e la mancanza e la lentezza della costruzione di più trasmissioni.

Chiaramente, la transizione dell'energia pulita sta rosicchiando quote ai combustibili fossili e ad un ritmo crescente.

Una breve nota sulla diffusione delle centrali a fissione nucleare, che hanno avuto un boom negli anni '60 e '70. Gli incidenti di Three Mile Island, Chernobyl e Fukushima hanno spinto il sentimento antinucleare,

nonostante l'energia da fissione fosse molto più sicura che bruciare combustibili fossili. Questo ha portato a ritardi normativi nell'approvazione delle centrali a fissione, con molti progetti che sono stati cancellati e hanno dovuto affrontare massicci superamenti dei costi.

Immergiamoci poi nel cuore della transizione dell'energia pulita per vedere come gli elettroni puliti (specialmente il solare) stanno crescendo così rapidamente, perché la maggior parte degli esperti e degli addetti ai lavori hanno sottovalutato la crescita e il loro ruolo fondamentale nella transizione dell'energia pulita.

2 Generazione di elettricità: Solare ed eolico

Non abbiamo mai visto tecnologie energetiche come il solare e l'eolico.

Per la prima volta nella storia, possiamo costruire industrialmente la generazione di energia. Una volta costruiti, gli impianti solari ed eolici costano molto poco per funzionare. In altre parole, sono fondamentalmente fonti di elettroni a

costo marginale zero.Il loro combustibile, la luce del sole o il vento, è gratuito e rinnovabile. Il solare in particolare è modulare e frazionabile, il che significa che un pannello può essere installato su un tetto o

letteralmente milioni di pannelli in un sito.

Hanno anche guadagnato trazione velocemente, una velocità mai vista prima nella storia, come mostra il seguente grafico. Naturalmente, poiché la diffusione continua ad aumentare, il ritmo probabilmente rallenterà un po' nei prossimi anni.

Il solare e l'eolico mostrano

curve di apprendimento ripide e consistenti (note anche come curve di esperienza). Cioè, diventano più economici da costruire man mano che più unità vengono costruite e utilizzate. Questa caratteristica delle

tecnologie a rapida scalabilità non si è mai applicata alle fonti di energia a combustibile fossile.

Queste energie pulite non mostrano segni di rallentamento. Il 2010 è stato uno dei migliori decenni del solare, come mostra il grafico qui sotto. La crescita è forte, le riduzioni dei costi drastiche, e l'industria sta innovando e imparando a ridurre ulteriormente i costi a velocità.

La capacità installata è cresciuta di oltre il 33% CAGR durante il decennio. Questo è un ritmo vertiginoso considerando che centinaia di milioni di moduli vengono prodotti ogni anno su questa scala. Anche la riduzione dei costi è stata forte, con un calo annuale del costo per watt di oltre il 16% durante gli anni 2010 contro il 12% degli ultimi 44 anni.

Infine, il tasso di apprendimento, che è il tasso di riduzione dei costi per ogni raddoppio della capacità, è stato anche molto meglio che nel periodo precedente. Il tasso di apprendimento a lungo termine del solare è di circa il 23,6% dal 1976, ma questo è salito a quasi il 35% negli anni 2010.

Come discuteremo, anche per gli addetti ai lavori più ottimisti questa crescita era inaspettata.

Ci sono cicli di feedback positivi dalla combinazione delle tecnologie, come abbiamo visto nelle transizioni passate. Stiamo iniziando a vedere più impianti solari accoppiati con lo stoccaggio agli ioni di litio, aiutando a risolvere molte delle limitazioni delle rinnovabili variabili. Queste due tecnologie sono reciprocamente vantaggiose e si aiutano a vicenda a guadagnare dai fattori di scala. Ci sono stati dei fenomeni analoghi nel passato: carbone, ferro e motore a vapore; petrolio, acciaio e motore a combustione interna; elettricità, alluminio e linee di trasmissione.

Diamo prima un'occhiata a come il solare in particolare è decollato per poi approfondire la discussione della transizione verso l'energia pulita.

2.1 Adozione solare: Lento, poi tutto in una volta

Se non diversamente specificato, le statistiche e i riferimenti in questa sezione sono tratti da

How Solar Energy Became So Cheap di Greg Nemet. I moduli solari fotovoltaici (PV) hanno iniziato a risolvere problemi in piccole nicchie di mercato. Con l'aumento della produzione, i costi sono scesi e le prestazioni dei moduli hanno continuato a migliorare. Il solare ha continuato ad entrare in mercati più grandi, come il tetto e più tardi l'energia su scala industriale, che ha continuato a guidare una forte crescita.

Visualizzare 40 anni di crescita non lineare

Un punto importante da ribadire è quanto sia difficile cogliere le tendenze non lineari. Prendiamo il solare dal 1976. In media, la capacità distribuita dei moduli è cresciuta di quasi il 40% all'anno, mentre i costi sono scesi di oltre il 12% all'anno.

Che aspetto ha questo fenomeno?

La crescita del solare è un'eccellente dimostrazione del ciclo di feedback positivo che abbiamo discusso per le tecnologie basate sulla manifattura di prodotti. Poiché i combustibili fossili non sono tecnologie di questo tipo, i costi non scendono costantemente per un lungo periodo di tempo. Gli impianti a carbone e a gas naturale mostrano

tassi di apprendimento, ma il costo dei combustibili stessi è

aumentato nel corso dei decenni perché le risorse facili da estrarre si sono esaurite, facendo salire i costi operativi.

Ora, se qualcuno avesse dato solo un'occhiata a questo grafico, avrebbe potuto supporre che la capacità del solare installato fosse fondamentalmente zero fino al 2000. Potrebbe anche pensare che i prezzi dei moduli solari sono stati vicini allo zero dai primi anni 2010.

Avrebbero torto su entrambi i fronti. La crescita composta e la riduzione dei costi guidano enormi cambiamenti di scala che sono difficili da leggere su assi lineari.

C'è un modo inizialmente più difficile da leggere, ma molto più utile per esprimere questi grandi cambiamenti, come mostrato in questo grafico. Usa assi logaritmici, rendi l'asse x di capacità cumulativa e segna il tempo sulla serie di dati stessa.

Adattato da Our World in Data. Ogni linea verticale segna un aumento di dieci volte della capacità installata.

Come possiamo vedere, la crescita del solare e le riduzioni dei costi sono state molto consistenti nel corso di diversi decenni, con alcuni sbalzi (della durata di qualche anno) lungo la strada. Gli ultimi dieci anni hanno visto la più grande riduzione relativa dei costi di sempre. Come discuteremo più avanti, non sembra che la crescita del solare stia rallentando.

Una breve storia della crescita del solare

Nel 1954, i Bell Labs svilupparono le prime celle solari al silicio. Alla fine degli anni '50, i primi moduli solari fotovoltaici erano usati per alimentare i trasmettitori radio sui satelliti della marina statunitense.

Durante gli anni '60, il governo degli Stati Uniti ha acquistato 150 milioni di dollari per 10 milioni di celle solari, così come vetro e componenti solari fotovoltaici. Avrebbero anche investito nella R&S solare durante gli anni 70 come risposta alle crisi petrolifere. Questo ha contribuito a far scendere i costi del solare di ben 5 volte dal 1974 al 1981, nonostante fosse ancora un piccolo mercato nascente con vendite dell'industria statunitense di soli 100 milioni di dollari nel 1982.

Negli anni '70 e '80, aziende giapponesi come la Sharp hanno continuato a trovare mercati più di nicchia per il solare, come i fari e l'elettronica di consumo - ricordate le calcolatrici a energia solare? Hanno superato i produttori statunitensi all'inizio degli anni '80, ma hanno ristagnato negli anni '90, quando non c'erano mercati più grandi in cui vendere.

Nel frattempo la California si stava preparando a giocare un ruolo di catalizzatore nello sviluppo del solare e dell'eolico. C'era una nuova legislazione sull'energia pulita appena introdotta e le aspettative di continui aumenti dei prezzi del petrolio dopo la crisi energetica del 1979. Ciò ha permesso di finanziare e costruire circa un miliardo di dollari di progetti eolici e solari termici prima che i prezzi del petrolio tornassero indietro.

Negli anni '90 e 2000, la Germania sarebbe cresciuta fino a diventare di gran lunga il più grande mercato per il solare fotovoltaico dell'epoca. La politica ha giocato un ruolo enorme, sovvenzionando più di 200 miliardi di euro di solare sui tetti e rappresentando più della metà delle installazioni globali di fotovoltaico dal 2004 al 2010. I produttori tedeschi come Q-Cells si sono ingranditi per servire il mercato, ma dalla metà degli anni 2000, le startup cinesi stavano rapidamente prendendo la quota di mercato.

Nei primi anni 2000, le startup solari emergenti della Cina hanno lavorato più velocemente e hanno beneficiato della tempistica per espandersi nel mercato tedesco. La cosa più importante è che si concentravano incessantemente sulla qualità e sul basso costo, cosa che i loro concorrenti tedeschi non facevano. I produttori tedeschi hanno anche dovuto sviluppare più attrezzature di produzione su misura (spesso adattate dall'industria dei semiconduttori). Ma quando poi sono stati acquistati dalle aziende cinesi, le attrezzature erano diventate più standardizzate e costavano meno.

E le previsioni dei fondatori del settore, degli addetti ai lavori e degli esperti?

Gregory Nemet, autore di

How Solar Energy Became Cheap, voleva capirlo. Tra il 2008 e il 2011, ha chiesto a 65 pionieri del business solare, politici e accademici di prevedere il costo del solare nel 2030.

Nel 2018, la realtà aveva già superato le previsioni degli esperti con dodici anni di anticipo. Il costo dell'elettricità a energia solare era già inferiore alle previsioni mediane per il 2030. Ricordate, questi non erano opinionisti, ma persone che avevano costruito l'industria.

L'AIE, il principale ente energetico mondiale, e i principali esperti di energia hanno

costantemente sottovalutato la crescita del solare negli ultimi 20 anni. Quello che è successo al costo del solare negli ultimi 10 anni è arrivato più di un decennio prima delle previsioni degli esperti.

Perché i modelli e gli esperti si sono sbagliati così tanto?

In breve, penso che il solare si sia espanso in mercati più grandi più velocemente di quanto chiunque pensasse possibile. Accanto a questo, ha continuato a guidare la riduzione dei costi nel processo, accelerando anche nell'ultimo decennio.

I modelli hanno sottovalutato questo ciclo di feedback nell'ascesa (ancora) precoce del solare e nell'espansione in mercati più grandi.

Come il team di Oxford ha discusso, le previsioni hanno usato

limiti arbitrari ai tassi di crescita non coerenti con i modelli storici, e altrettanto arbitrari "costi di base" che sono stati inseriti nei modelli.

I tassi di apprendimento per il solare sono stati più veloci dal 2010 che nei decenni precedenti. Come discusso in precedenza, i tassi di apprendimento nell'ultimo decennio sono stati quasi del 35%, al di sopra della media a lungo termine del 24% dal 1976.

Ci sono diverse ragioni per cui il LCOE del solare è sceso ancora più velocemente della media storica. La tecnologia del solare fotovoltaico continua a migliorare man mano che la produzione aumenta.

Un gruppo che chiaramente non ha dato retta alle previsioni di crescita lenta sono stati i produttori di energia solare. Essi beneficiano sempre più delle economie di scala e della standardizzazione nella produzione. I progetti solari sono sempre più costruiti su scala di grandi impianti, che ora sono fino a più gigawatt di dimensioni. Questo ha permesso di

ridurre ancora di più i costi degli elementi degli impianti che non sono moduli per i progetti solari su scala industriale. Infine, i pannelli solari stanno diventando più durevoli con

garanzie più lunghe offerte nel tempo, con un grande produttore

che ora offre 40 anni di garanzia!

2.4 Intermittenza

L'intermittenza è il problema del sole che non sempre splende e del vento che non sempre soffia.

Dato che è stato aggiunto più solare nelle reti elettriche, come il CAISO della California e l'Australia del Sud, ci possono essere giorni di sole con troppo solare per la rete da gestire (il fenomeno della

curva a collo d'anatra). Nelle reti con un'alta penetrazione solare come le due citate, si crea la necessità di risolvere l'intermittenza giornaliera.

C'è anche il problema dell'intermittenza di più lunga durata, che può essere di diversi giorni, o degli squilibri stagionali. In una zona dove un inverno è particolarmente nuvoloso, la

capacità solare può diminuire della metà o più in un mese rispetto alla media annuale.

Le soluzioni sono però a portata di mano. Per le durate più brevi, i grandi progetti di stoccaggio agli ioni di litio forniscono fino a quattro ore di stoccaggio praticabile per le energie rinnovabili con l'attuale economia dell'unità. Stanno

iniziando ad apparire progetti di stoccaggio di otto ore. La prima implementazione su scala di rete è stata fatta da Tesla in Sud Australia nel 2017, con lo stato che

non ha subito un blackout né ha avuto bisogno di "liberarsi" di energia pulita da allora.

Stoccaggio di quattro ore abbinato al solare a

Kuai'i, Hawaii, 2017.

Lo stoccaggio accoppiato al solare

può aggiungere più valore alle reti ad alto contenuto di rinnovabili rispetto allo stoccaggio da solo, specialmente durante le ore di punta serali. Inoltre, dato che i prezzi delle batterie continuano a scendere, sarà possibile uno stoccaggio di durata maggiore,

forse 12 ore. Parleremo di più delle batterie e del mercato dello stoccaggio nella prossima sezione.

Lo stoccaggio di più lunga durata ha molte soluzioni di energia pulita come l'idroelettrico a pompaggio, immagazzinamento meccanico e varie soluzioni elettrochimiche come le batterie ferro-aria.

Non mancano i finanziamenti per queste tecnologie emergenti. È ancora troppo presto per dire quali tecnologie beneficieranno di più dei fattori di scala, ma probabilmente quelle che usano materiali a basso costo e hanno alti tassi di apprendimento.

Infine, la rete potrebbe non aver bisogno di così tanto stoccaggio come si pensa, anche se certamente ne avremo molto bisogno.

Un recente articolo pubblicato su Nature ha usato dei

modelli trovando che se si arriva a far produre al solare e il vento forniscono 1,5x di tutta la capacità elettrica, solo 3 ore di stoccaggio di batterie accoppiate funzionerebbero bene. Ne risulterebbe una carenza di elettricità per meno di 200 ore all'anno. Probabilmente anche meno carenze sarebbero venute fuori dai modelli se le batterie distribuite (diciamo nei veicoli elettrici) fossero state incluse nell'analisi.

2.5 Aggiornamenti della trasmissione

Trasmettere energia pulita su scala industriale da aree solari o ricche di vento richiede la costruzione di più linee di trasmissione ad alta tensione. Queste linee sono spesso costose, e si impantanano nella burocrazia dei permessi che può richiedere

10 anni per l'approvazione e la installazione.

Naturalmente, abbiamo bisogno di linee di trasmissione solo nei casi in cui gli elettroni puliti sono generati lontano da dove vengono utilizzati, come i centri urbani e gli hub di produzione.

Per muoversi più velocemente e avere accesso a elettroni economici e puliti direttamente, le industrie affamate di elettricità si stanno sempre più collocando accanto agli impianti solari ed eolici. In questo modo, gli sviluppatori di energie rinnovabili evitano di pagare le tasse di interconnessione, mentre le nuove industrie alimentate da elettroni ultra-economici possono ottenere l’elettricità più economica possibile senza un'azienda che faccia da intermediario. Parleremo di questo più tardi.

L'altro lato di questo argomento è naturalmente l'installazione di progetti solari su piccola scala in aree dove l'energia è già utilizzata. Il solare sui tetti, le microreti e lo stoccaggio di energia per le case e l'industria sono in crescita. Queste risorse energetiche distribuite (DERs in gergo energetico) possono mantenere le luci accese durante eventi meteorologici estremi,

anche se tutte le linee elettriche di una città vengono meno.

In molti scenari, è necessario costruire più trasmissione. Per permettere un maggior numero di impianti solari ed eolici su scala industriale, sono necessarie riforme e aggiornamenti delle infrastrutture. Questo spazio ha visto un'

attività promettente da parte dei regolatori statunitensi di recente e

disegni di legge che permettono di costruire più velocemente le linee di trasmissione lungo le strade e le ferrovie. Ci sono anche

startup che lavorano per aumentare la capacità delle linee esistenti e ottimizzarle.

In realtà, la maggior parte dei paesi sta scalando sia l'energia pulita distribuita che quella su scala industriale, dato che entrambi i tipi offrono valore oltre ad essere a bassa emissione di carbonio.

2.6 È probabile una forte crescita in futuro

L'energia solare ed eolica sono probabilmente ancora in una fase iniziale della loro adozione e continueranno a vedere una forte crescita. I seguenti punti rendono l'idea.

Il solare e l'eolico continuano a far scendere i costi con l'aumento della diffusione

Il costo dell'elettricità a energia solare è diminuito del 35% per raddoppio industriale nell'ultimo decennio. Il tasso di apprendimento attuale è più veloce del 24% del 1976, ma ha senso data la rapida crescita e la concorrenza dei produttori cinesi dalla metà degli anni 2000 discussa in precedenza.Il solare e l'eolico superano i combustibili fossili in molti luoghi

I nuovi progetti solari o eolici su scala industriale sono già più economici che gestire le centrali a carbone e a gas naturale esistenti

nei paesi che costituiscono il 46% della popolazione mondiale. Come mostrato nel grafico qui sotto, il solare è più economico per la Cina, l'India e la maggior parte dell'Europa occidentale; l'eolico in Danimarca, Brasile, Regno Unito, Marocco e altri. Negli Stati Uniti, il

61% delle centrali a carbone esistenti sono più costose delle rinnovabili. Il solare e l'eolico sono

competitivi con le centrali a gas naturale esistenti.

Fonte. Questa mappa mostra la tecnologia con il più basso costo livellato dell'energia (costo dell'elettricità spalmato sulla durata del bene) per i nuovi impianti solari ed eolici rispetto ai costi marginali (operativi e di combustibile) per le centrali esistenti a carbone e a gas.

Come accennato prima, l'82% della nuova generazione di elettricità a livello globale è stata prodotta da fonti rinnovabili nel 2020. Il

carbone è in declino quasi terminale, con impianti proposti che vengono cancellati a un ritmo storico. L'uso del gas naturale per tutti gli usi, compresi elettricità, carburante e calore,

potrebbe aver raggiunto il picco negli Stati Uniti nel 2019. Il declino del gas per la produzione di elettricità sarà probabilmente accelerato dal picco globale dei prezzi alla fine del 2021. Man mano che il solare e l'eolico diventano la fonte più economica di elettroni in un numero sempre maggiore di paesi, aspettatevi una quantità crescente di attrezzature per i fossili esistenti non recuperabili.

Il caso di chiudere e sostituire le centrali fossili esistenti diventa ogni anno più convincente.

Il solare distribuito e l'eolico offshore riducono la necessità di linee di trasmissione

Come menzionato in 2.4, i miglioramenti della trasmissione sono costosi e richiedono molti anni anche per approvare nuovi impianti solari su scala industriale.

Il solare distribuito può integrare le energie rinnovabili su scala industriale. I tipi includono tetti residenziali, commerciali e industriali, microgrids e installazioni solari fuori sede.

Il solare distribuito, le batterie e altre risorse

possono effettivamente ridurre i costi dell'elettricità della rete e persino permettere la costruzione di più fonti rinnovabili su scala industriale.I FV solari, per progettazione, sono abbastanza piccoli e modulari da essere distribuiti vicino o dove viene utilizzato. Il solare su tetto ha avuto un boom nei paesi dove le risorse solari sono grandi, i costi del sistema sono economici, le politiche di misurazione netta significano un alto ROI, e i processi di autorizzazione sono veloci. Per esempio, il

30% delle case australiane ha già installato il solare sul tetto, ed entro il 2025, il solare fornirà tutti gli elettroni necessari, perlomeno in certi momenti.

Gli Stati Uniti sono un paese in cui il solare su tetto è inutilmente costoso. Una

combinazione di costi di autorizzazione e di burocrazia a livello cittadino, di restrizioni di codici arcani e di costi di acquisizione dei clienti molto alti hanno reso il solare su tetto negli Stati Uniti molto meno accessibile. Il che significa, ovviamente, meno adozione. Al contrario, l'Australia ha snellito i permessi, semplificato i codici e abbassato i costi di acquisizione dei clienti e di installazione del lavoro. Il risultato? Il solare su tetto è quasi tre volte più costoso negli Stati Uniti. Gli Stati Uniti sembrano solo ora decidersi a fare passi avanti per ridurre i costi e i rallentamenti con l'iniziativa pubblica/privata

SolarAPP per automatizzare i permessi, e la California che sta cercando di

approvare la propria legge per costruire su SolarAPP.

Ci sono più tetti che vengono aggiunti solo per permettere più elettroni generati dal sole. Le stazioni di ricarica EV stanno iniziando ad aggiungere

carport coperti con tetti fotovoltaici e batterie fisse. Questo rende i siti di ricarica dei veicoli elettrici più economici, consentendo alle aziende di evitare gli oneri di domanda, che possono costituire la metà della bolletta di un'azienda ad alta intensità energetica. Permette anche ai ristoranti e ad altri spazi commerciali di adottare microreti, risparmiando sui costi dell'elettricità e avendo energia di riserva durante le interruzioni.

Fonte. Le aziende vedono sempre di più un miglioramento economico e i clienti ottengono la ricarica dei veicoli elettrici integrando l'energia solare e lo stoccaggio nei loro locali esistenti.

Il solare comunitario è un altro tipo promettente di energia distribuita. Copre un ampio ombrello di installazioni solari che permettono ai benefici finanziari di essere distribuiti tra molte persone. Questi progetti potrebbero permettere a

due terzi degli americani e a miliardi di persone nel mondo che non possono installare il solare sul tetto di accedere all'energia pulita locale. Un enorme vantaggio è che il solare comunitario di solito non richiede aggiornamenti della trasmissione. La capacità solare della comunità statunitense è cresciuta al

130% CAGR durante il 2010-2020, superando di gran lunga anche l'aumento stellare generale del solare.

Le turbine eoliche offshore possono anche aiutare ad alleviare le sfide di trasmissione, essendo situate vicino ai

centri di popolazione costiera affamati di energia. La capacità dei parchi eolici offshore globali è aumentata di 11 volte dal 2010-2020 (27% CAGR). Una crescita ancora maggiore è in vista, con nove volte la quantità di capacità attuale in cantiere, come mostrato qui sotto. Le

velocità del vento in mare sono più alte, più costanti e spesso raggiungono il picco quando è più necessario, durante il pomeriggio e la sera.

Dati da Energy Monitor. Include i dieci paesi con la maggiore capacità pianificata. Classificati dal più pianificato al meno: Regno Unito, Brasile, Cina, Giappone, Stati Uniti, Irlanda, Corea del Sud, Taiwan, Svezia, Germania.

L'energia eolica continuerà a diventare più economica. I costi dell'elettricità dall'eolico offshore a livello globale sono diminuiti di

quasi la metà in 10 anni, con un calo del 9% solo nel 2020 e i risultati delle aste suggeriscono un'altra diminuzione del 40% entro il 2023. Negli Stati Uniti, le

code di progetti eolici offshore in piena espansione sono molto promettenti, ma richiedono alcuni problemi di trasmissione da risolvere. Infine, le

risorse eoliche offshore sono particolarmente abbondanti vicino ai poli terrestri, il che le rende molto complementari all'energia solare che favorisce l'equatore.

Per non essere da meno, le turbine eoliche onshore a fine vita possono essere

ripotenziate. Questo significa che gran parte della struttura può essere riutilizzata e nuove turbine possono essere installate, risparmiando sui costi ed eliminando lunghi ritardi e costi di interconnessione. Questo è già successo in Danimarca, per esempio.

Si continueranno a trovare nuovi usi per il solare fotovoltaico. Tendiamo a pensare che il solare fotovoltaico sarà usato solo per produrre elettricità. Ma è probabile che vedremo altri nuovi usi e integrazioni man mano che il solare continuerà a diventare più economico.

Un esempio è il crescente slancio per i sistemi fotovoltaici integrati negli edifici (

BIPV). Questi sistemi possono sostituire le facciate esistenti, come per l'

edificio svizzero nella foto qui sotto, o sostituire le tegole/tegole del tetto (si pensi al tetto solare di Tesla).

Questa facciata solare copre più di 1142 m2 dell'edificio. Poiché la superficie è verticale, produce più energia in inverno. Un altro esempio è il solare fotovoltaico che può produrre acqua.

Source Global distribuisce "idropannelli" che producono acqua potabile pulita usando il fotovoltaico solare per condensare il vapore acqueo. Viene usato per comunità remote e per la conservazione dell'acqua in aree colpite dalla siccità come la Central Valley della California.

Il sistema solare ad acqua della Source Global produce acqua potabile dalla luce del sole e dal vapore acqueo, anche nei climi aridi.

_________________________________________________________________________

Da qui in poi, Xu va vanti per oltre 100 pagine con un analisi del funzionamento delle batterie, della fusione e fissione nucleare, di nuovi materiali ottenibili con energia a basso costo, e altre prospettive per il futuro.